Материалы по тегу: sambanova systems

|

23.01.2026 [13:07], Руслан Авдеев

Застопорившаяся сделка с Intel заставила SambaNova искать $500 млн дополнительных инвестицийПоставщик ИИ-ускорителей SmabaNova рассчитывает привлечь до $500 млн в ходе раунда финансирования после того, как приостановились переговоры с Intel. Последняя рассматривала возможность покупки SambaNova, пишет Bloomberg. Ранее появилась информация, что компании вели расширенные дискуссии о возможном поглощении SambaNova, включая долг, компанией Intel за $1,6 млрд, но окончательное решение так и не было принято. Переговоры пока не принесли результатов, и поставщик ИИ-решений теперь ищет инвестиции из других источников — технологических компаний и производителей полупроводников. При этом глава Intel Лип-Бу Тан (Lip-Bu Tan) одновременно является председателем SambaNova. Первые слухи о том, что SambaNova рассматривает возможность продажи, появились в октябре 2025 года. По данным источников The Information, компания наняла инвестиционную структуру для того, чтобы та курировала потенциальную покупку. В 2021 году SambaNova оценивалась в $5 млрд, а всего с момента основания привлекла более $1,1 млрд от инвесторов, включая GV, Intel Capital, BlackRock и SoftBank Vision Fund. Однако BlackRock, владеющая акциями SambaNova, ранее снизила оценку до $2,4 млрд. Теперь же, по-видимому, даже оценка в $1,6 млрд не является корректной. Основанная в 2017 году SambaNova изначально ориентировалась на обучение ИИ-моделей, но затем переключилась на услуги облачного и локального инференса с использованием собственных ИИ-чипов SN40L, представленных в сентябре 2023 года.

10.12.2025 [20:02], Владимир Мироненко

Intel договорилась о покупке разработчика ИИ-ускорителей SambaNova за $1,6 млрд, но не окончательноРесурсу Wired стало известно о подписании Intel соглашения о покупке ИИ-стартапп SambaNova Systems. Финансовые условия соглашения, которое носит предварительный характер и не имеет обязательной силы, не разглашаются. Впервые о заинтересованности Intel в приобретении стартапа сообщил Bloomberg в конце октября. На тот момент переговоры находились на ранней стадии. Согласно данным ресурса, сумма предполагаемой сделки составляла менее $5 млрд. Что примечательно, генеральный директор Intel Лип-Бу Тан (Lip-Bu Tan) в настоящее время является исполнительным председателем и инвестором SambaNova Systems, сообщили источники The New York Times, знакомые с ситуацией. И он рассказывал о предложениях SambaNova на встречах как минимум с одним крупным клиентом Intel, компанией Dell. Intel Capital, которую сейчас выделяют в отдельную компанию, также инвестировала в SambaNova Systems. Ещё один инвестор SambaNova, японская SoftBank Group, также является крупным инвестором Intel. SambaNova Systems была основана в 2017 году в Пало-Альто (Palo Alto, Калифорния, США) Кунле Олукотуном (Kunle Olukotun), Родриго Ляном (Rodrigo Liang) и Кристофером Ре (Christopher Ré). Олукотун и Ре — профессора Стэнфордского университета. Лян ранее был топ-менеджером в Oracle. По данным PitchBook, к началу 2025 года компания привлекла $1,14 млрд инвестиций. В частности, в 2020 году она получила $250 млн от BlackRock, Intel Capital, венчурной фирмы GV и других инвесторов, а её оценка выросла до $2,5 млрд. В 2021 году SambaNova была оценена в $5 млрд после раунда финансирования в размере $676 млрд, возглавляемого фондом SoftBank Vision Fund 2. С тех пор предполагаемая оценка стартапа снизилась. По данным The Information, BlackRock снизила стоимость своих акций SambaNova на 17 % за последний год. Это, вероятно, сделало компанию целью для Intel, наряду с тем фактом, что Intel отстаёт от остальной части индустрии чипов в производстве ИИ-чипов, отметил Wired. Разработки купленной когда-то Habana едва продаются, а после отказа от Ponte Vecchio, проблем с запуском Falcon Shores и неопределённостью относительно Jaguar Shores у Intel практически не осталось «больших» ускорителей. О сделке с Nervana в компании предпочитают не вспоминать. SambaNova разрабатывает ИИ-ускорители на основе реконфигурируемого блока обработки данных (Reconfigurable Dataflow Unit, RDU). 5-нм ускоритель SN40L, представленный более двух лет назад, имеет 1040 ядер RDU, обеспечивающих производительность до 653 Тфлопс в режиме BF16. Он оснащён 520 Мбайт SRAM, 64 Гбайт HBM3 с внешним DDR5-массивом объёмом 1,5 Тбайт для размещения LLM. Компания фактически отказалась от попыток конкурировать с NVIDIA в задачах обучения ИИ. Вслед за Groq она переключилась на инференс и поставку готовых ИИ-платформ вместо продажи ускорителей. UPD 13.12.2025: по данным Bloomberg, переговоры между компаниями значительно продвинулись — Intel готова приобрести SambaNova за $1,6 млрд с учётом долгов последней. Если сделка состоится, она станет первой крупной покупкой «синих» под руководством Лип-Бу Тана.

02.11.2025 [12:03], Сергей Карасёв

Intel интересуется покупкой разработчика ИИ-ускорителей SambaNova Systems, в которого инвестировал сам Лип-Бу ТанКорпорация Intel, по сообщению Bloomberg, ведёт предварительные переговоры о покупке стартапа SambaNova Systems, специализирующегося на разработке ИИ-ускорителей. Сделка теоретически позволит Intel укрепить конкурентное положение по отношению к NVIDIA. SambaNova основана в 2017 году профессорами Стэнфордского университета (Stanford University) в США. Компания занимается созданием ускорителей RDU (Reconfigurable Dataflow Unit) для работы с большими языковыми моделями (LLM) и инференса. С момента своего появления SambaNova привлекла более $1,1 млрд от GV, Intel Capital, BlackRock, SoftBank Vision Fund и др. В 2021 году стартап был оценён в $1,1 млрд. Однако в последнее время компания столкнулась со сложностями: ей не удалось провести очередной раунд финансирования, а рыночная стоимость пошла на спад. Весной нынешнего года SambaNova сократила численность персонала на 15 %, уволив 77 из 500 сотрудников. Тогда говорилось, что компания намерена переориентироваться на предоставление облачного ИИ-инференса. А недавно стало известно, что SambaNova изучает возможность продажи бизнеса.

Источник изображения: SambaNova По сведения Bloomberg, к SambaNova присматривается Intel. Уточняется, что переговоры находятся на начальной стадии, поэтому сделка может не состояться. Кроме того, не исключатся вероятность появления другого покупателя. Представитель SambaNova, не вдаваясь в детали, заявил, что компания «ищет стратегические возможности, которые соответствуют её миссии и интересам акционеров». В Intel от комментариев отказались. Нужно отметить, что нынешний генеральный директор Intel Лип-Бу Тан (Lip-Bu Tan) одновременно является председателем правления SambaNova. Его венчурная компания Walden International была одним из первых инвесторов SambaNova, возглавив раунд финансирования Series A на сумму $56 млн в 2018 году. Таким образом, для Тана компания SambaNova — это хорошо знакомый бизнес. Для самой Intel попытки закрепиться на рынке «большого» ИИ оказались не слишком успешными. Приобретение Nervana (Lake Crest/Knights Crest) закончилось полным провалом, а создававшиеся в то же время собственные Xeon Phi компания в итоге забросила. Продажи ускорителей поглощённой когда-то Habana оставляют желать лучшего, так что сейчас компания, по-видимому, пытается хоть как-то сбыть их остатки. Собственные Ponte Vecchio (Intel Max) компания так же оставила без поддержки, Falcon Shores она решила никому не продавать, а будущее Jaguar Shores не известно.

28.10.2025 [15:02], Руслан Авдеев

SambaNova может быть выставлена на продажу — компании не удалось привлечь достаточно средствРазработчик ИИ-ускорителей SambaNova Systems изучает возможность продажи бизнеса. Компании не удалось вовремя завершить очередной рануд финансирования. По данным источников, знакомых с вопросом, она уже наняла инвестиционную компанию для контроля продажи, но переговоры продолжаются, т.ч. SambaNova всё ещё может передумать, сообщает The Information. Исполнительным председателем компании является Лип-Бу Тан (Lip-Bu Tan), нынешний глава Intel. В 2021 году капитализация компании оценивалась в $5 млрд. С момента основания SambaNova привлекла более $1,1 млрд, инвесторами выступили GV, Intel Capital, BlackRock и SoftBank Vision Fund. Издание говорит об отчёте Caplight, в котором указано, что BlackRock снизила оценочную стоимость своих акций в компании на 17 %, в результате чего общая оценка капитализации SambaNova упала до $2,4 млрд. SambaNova не прокомментировала возможную продажу, а её представитель заявил, что компания всегда оценивает стратегические возможности, поддерживающие её миссию, а также интересы владельцев. Основанная в 2017 году калифорнийская компания специализировалась на ИИ-ускорителях для обучения LLM, но в 2025 году сменила профиль на предоставление облачных ИИ-сервисов и инференс, повторив подход Groq. Последней, правда, повезло больше — она активно заключает сделки, получает инвестиции и создаёт ИИ ЦОД. У Cerebras дела идут ещё лучше, хотя и не идеально. Cerebras, Groq и SambaNova стали чуть ли не единственными компаниями, которые относительно успешно смогли конкурировать с NVIDIA и AMD на рынке «больших» ИИ-ускорителей. Последний продукт SambaNova — готовый ПАК SambaManaged на базе представленного два года назад ускорителям SN40L — популярности пока не снискал. Если SambaNova решится на продажу, она пополнит растущие ряды стартапов по выпуску ИИ-чипов, купленных за последние 12 месяцев. Так, Meta✴ объявила о покупке за неназванную сумму стартапа Rivos, занимающегося разработкой чипов на архитектуре RISC-V. Хотя сумма сделки неизвестна, ранее сообщалось, что стартап рассчитывал привлечь $500 млн с капитализацией $2 млрд. За полгода до этого южнокорейская FuriosaAI, тоже разрабатывающая ИИ-чипы, отклонила предложение Meta✴ о покупке за $800 млн. В этом году 2025 года SoftBank заявила о приобретении Ampere Computing за $6,5 млрд, а в прошлом году она приобрела разработчика ИИ-ускорителей Graphcore, у которого тоже были проблемы с финансами. Впрочем, бывают ситуации и похуже. Например, летом AMD купила команду разработчика ИИ-чипов Untether AI, но не саму компанию, которая тут же закрылась, оставив за бортом текущих клиентов стартапа. У Esperanto, создателя уникального тысячеядерного RISC-V-ускорителя, всех инженеров переманили крупные компании. Одним из возможных покупателей SambaNova называют Oracle, которая, по слухам, заинтересована именно в команде разработчиков, а не самих чипах.

09.07.2025 [16:30], Руслан Авдеев

SambaManaged превратит почти любой ЦОД в ИИ ЦОД всего за три месяцаРазработчик ИИ-ускорителей SambaNova анонсировал решение SambaManaged на базе SN40L. Это первый в отрасли продукт, оптимизированный для инференса, внедрить который можно всего за 90 дней — намного быстрее, чем обычно требуется для систем такого уровня (18–24 мес.), говорит компания. Модульная платформа разработана специально для быстрого развёртывания и позволяет существующим дата-центрам почти немедленно организовать ИИ-инференс с минимальными модификациями инфраструктуры. По мере того, как стремительно растёт спрос на ИИ-задачи, связанные именно с инференсом, традиционные дата-центры сталкиваются с новыми проблемами — на внедрение систем, оптимизированных для таких задач, требуется от полутора до двух лет, много энергии, а также дорогостоящие обновления оборудования. Решение SambaManaged позволяет устранить эти барьеры, быстро развернув прибыльные инференс-сервисы, используя уже имеющуюся силовую и сетевую инфраструктуру. SambaManged формируется из стоек SambaRack SN40L-16, каждая из которых включает 16 ускорителей (RDU в терминологии SambaNova) SN40L с BF16-производительностью 10,2 Тфлопс. Платформа оснащена двумя 64-ядерными хост-процессорами, 2 Тбайт DDR4, четырьмя загрузочными 960-Гбайт SSD (RAID1 + два hot-spare) и шестью 7,6-Тбайт NVMe SSD в RAID10 для данных. Энергопотребление составляет всего 7–14,5 кВт (типовое 10 кВт). Стойка весит 485 кг. Рабочая температура — от +15 до +30 °C. Фактически это переименованная платформа DataScale SN40L, только теперь разработчик не говорит о возможности обучения моделей. Как подчёркивают в SambaNova, дата-центры сталкиваются с проблемами энергоснабжения и охлаждения, недостатком компетенций и др. на фоне роста спроса на ИИ. Система SambaManaged обеспечивает высокую ИИ-производительность при низком энергопотреблении и минимальных изменениях инфраструктуры. Преимуществами для ЦОД и облачных провайдеров называются рекордная производительность на каждый затраченный Вт, позволяющая снизить совокупную стоимость владения (TCO) и быстрее вернуть инвестиции. Систему можно внедрить всего за 90 дней. При этом обеспечивается невероятно быстрый инференс с ведущими open source моделями, что позволяет избежать привязки к конкретному вендору и гарантирует совместимость с будущими технологиями. Модульный дизайн позволяет быстро строить даже большие инференс-системы, включая т.н. Token Factory мощностью до 1 МВт (100 стоек). Систему можно масштабировать по мере изменения бизнес-потребностей. Можно выбрать полностью управляемое решение или взять на себя часть контроля за операциями. SambaManaged уже внедряется крупной публичной компанией в США, потребляющей немало энергии. Платформа обеспечивает максимальную пропускную способность для моделей вроде DeepSeek и ей подобных, помогая клиентам увеличивать доход от инференса и оптимизировать энергоэффективность (PUE). В SambaNova заявляют, что SambaManaged меняет правила игры для организаций, желающих ускорить реализацию ИИ-проектов без ущерба скорости, масштабу или эффективности. Везде, где есть доступ к Сети и электроэнергии, можно обеспечить необходимую инфраструктуру в рекордные сроки. В конце июня 2025 года сообщалось, что SambaNova делает ставку на инференс и партнёрство с облачными провайдерами и госзаказчиками из США. Groq, ещё один поставщик решений для инференса, первым сменил бизнес-подход, отказавшись от продажи ускорителей в пользу формирования целых ИИ ЦОД. Cerebras совместно с партнёрами также создаёт крупные ИИ-суперкомпьютеры и кластеры.

25.06.2025 [13:34], Руслан Авдеев

SambaNova делает ставку на инференс и партнёрство с облачными провайдерами и госзаказчикамиРазработчик ИИ-ускорителей SambaNova Systems объявил о стратегическом изменении профиля деятельности. Теперь основное внимание будет уделено инференсу, а не обучению ИИ-моделей, сообщает EE Times со ссылкой на главу компании Родриго Ляна (Rodrigo Liang). Тот считает, что в ближайшие годы инференс станет ключевым направлением в ИИ-секторе. Переосмысление стратегии привело к увольнению 77 сотрудников в апреле 2025 года. Компания всё ещё будет поддерживать обучение ИИ-моделей, но признаёт, что спрос на крупные кластеры для этих целей заметно снизился. Многие клиенты переходят на открытые модели, адаптируя и дообучая их — разработчики не желают создавать свои LLM с нуля. Поэтому теперь SambaNova будет предоставлять предприятиям и правительственным структурам инструменты для развёртывания открытых и доработанных моделей, в том числе «рассуждающих». Основными клиентами компании сегодня являются крупные предприятия и «суверенные» государственные заказчики, заинтересованные в сокращении затрат. У госзаказчиков особые требования, в частности — независимость от США и других стран. Кроме того, они используют модели, обученные на локальных данных и ориентированные на специфику национальных экономик. Поскольку стойки компании потребляют всего по 10 кВт, позволить их себе могут даже страны со слабой энергетической инфраструктурой.

Источник изображения: Magnet.me/unsplash.com Хотя у SambaNova есть собственная облачная инфраструктура с поддержкой открытых моделей, компания не намерена строить крупные кластеры для инференса. Вместо этого она организует партнёрство с облачными провайдерами, предоставляя им технологии для создания ИИ-облаков. Некоторыми партнёрами стали региональные облачные провайдеры, намеренные развернуть собственные ИИ-экосистемы. Платформа SambaNova Cloud играет роль демонстрационной площадки и не претендует на конкуренцию с другими провайдерами, являясь шаблоном, по образцу которого можно развёртывать аналогичные схемы «под ключ». Технологии SambaNova позволяют запускать до 100 разных копий Llama-70B в одной стойке. Это отличный вариант для компаний, которым нужны разные варианты моделей для финансового, юридического и других отделов, для разных целей. По словам компании, у конкурентов для каждой версии модели требуется стойка на 140 кВт, в то время как SambaNova позволяет использовать стойки на 10 кВт для запуска множества моделей, причём переключение с одной на другую осуществляется «за миллисекунду». Это позволяет компаниям экономить значительные средства. Осенью 2024 года SambaNova объявила о запуске самой быстрой на тот момент облачной платформы для ИИ-инференса. В этом она соревнуется с Cerebras и Groq, которые пытаются составить конкуренцию NVIDIA. Стоит отметить, что Groq также сменила бизнес-подход, отказавшись от продажи отдельных ускорителей в пользу оснащения целых ИИ ЦОД для инференса. Cerebras совместно с партнёрами создаёт крупные ИИ-суперкомпьютеры и кластеры. От обучения моделей она не отказывается.

28.04.2025 [07:54], Сергей Карасёв

SambaNova уволила 15 % персонала и переключилась на инференс в облакеРазработчик ИИ-ускорителей SambaNova, по сообщению EE Times, проводит реорганизацию, направленную на трансформацию бизнеса. Стартап, в частности, намерен сосредоточиться на предоставлении облачных услуг в сфере ИИ, включая, ресурсы для инференса. SambaNova была основана в 2017 году. Актуальный ИИ-ускоритель компании SN40L RDU (Reconfigurable Dataflow Unit) объединяет два крупных чиплета, которые оперируют 520 Мбайт SRAM-кеша, 1,5 Тбайт DDR5 DRAM и 64 Гбайт HBM3. Восьмипроцессорная система на базе SN40L, по заявлениям SambaNova, способна запускать и обслуживать ИИ-модели с 5 трлн параметров и глубиной запроса более 256k. Осенью прошлого года SambaNova объявила о запуске самой быстрой на тот момент облачной платформы для ИИ-инференса. В этом вопросе она соревнуется с Cerebras и Groq, ещё двумя заметными стартапами, которые пытаются составить конкуренцию NVIDIA. Стоит отметить, что Groq также сменила бизнес-подход, отказавшись от продажи отдельных ускорителей в пользу оснащения целых ИИ ЦОД для инференса.

Источник изображения: SambaNova В рамках реорганизации SambaNova сократила численность персонала примерно на 15 %: уволены 77 из 500 сотрудников. Отмечается, что масштабные коммерческие ИИ-нагрузки смещаются от обучения в сторону инференса. В результате стартапы в сфере ускорителей и другого ИИ-оборудования для дата-центров переключились на предоставление обалчного доступа к LLM посредством API. «Мы оперативно переориентировались на предоставление облачных решений, которые помогают предприятиям и разработчикам развёртывать открытые ИИ-модели в масштабе. В рамках трансформации операций пришлось принять трудное решение о сокращении примерно 75 сотрудников и сместить фокус команды для поддержания следующего этапа роста», — заявили представители SambaNova.

24.02.2025 [12:22], Сергей Карасёв

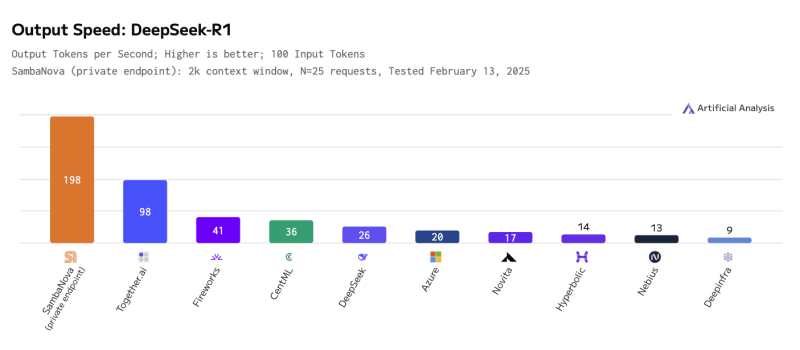

SambaNova развернула самую быструю инференс-платформу для ИИ-модели DeepSeek-R1 671BКомпания SambaNova объявила о том, что в её облаке SambaNova Cloud стала доступна большая языковая модель DeepSeek-R1 с 671 млрд параметров. При этом благодаря применению фирменных ускорителей SN40L обеспечивается рекордно высокая скорость инференса. Изделия SambaNova SN40L RDU (Reconfigurable Dataflow Unit) состоят из двух крупных чиплетов, оперирующих 520 Мбайт SRAM-кеша, 1,5 Тбайт DDR5 DRAM и 64 Гбайт памяти HBM3. Восьмипроцессорная система на базе SN40L, по заявлениям SambaNova, способна запускать и обслуживать ИИ-модели с 5 трлн параметров и глубиной запроса более 256k. Платформа SambaNova Cloud при использовании DeepSeek-R1 671B демонстрирует производительность до 198 токенов в секунду, что на сегодняшний день является рекордным показателем. Для сравнения: у ближайшего конкурента — Together AI — результат составляет 98 токенов в секунду, а у Microsoft Azure — 20 токенов в секунду. Ранее Cerebras объявила о собственном рекорде — до 1508 токенов/с, но для гораздо более скромной и, по мнению компании, практичной модели DeepSeek-R1-Distill-Llama-70B. Утверждается, что ускорители SambaNova SN40L RDU по сравнению с новейшими GPU обеспечивают в три раза большую производительность и в пять раз более высокую эффективность. В частности, по заявлениям SambaNova, одна стойка с 16 экземплярами SN40L RDU по быстродействию сопоставима с 40 стойками, насчитывающими в общей сложности 320 передовых GPU. Таким образом, существенно сокращаются затраты на использование DeepSeek-R1 671B. Доступ к DeepSeek-R1 671B в облаке SambaNova Cloud предоставляется посредством API. В перспективе компания планирует наращивать вычислительные мощности, обеспечив производительность на уровне 20 000 токенов в секунду.

11.09.2024 [18:07], Сергей Карасёв

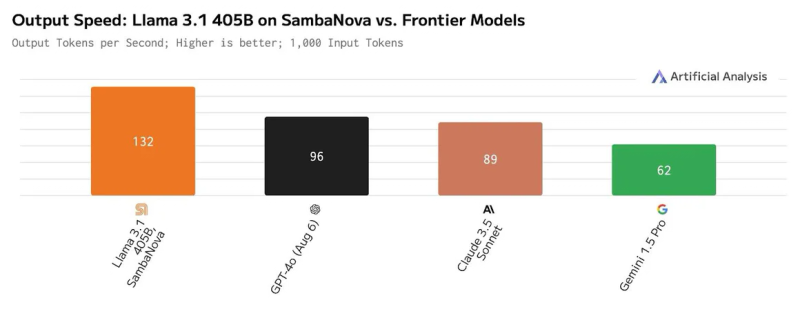

SambaNova запустила «самую быструю в мире» облачную платформу для ИИ-инференсаКомпания SambaNova Systems объявила о запуске облачного сервиса SambaNova Cloud: утверждается, что на сегодняшний день это самая быстрая в мире платформа для ИИ-инференса. Она ориентирована на работу с большими языковыми моделями Llama 3.1 405B и Llama 3.1 70B, насчитывающими соответственно 405 и 70 млрд параметров. В основу сервиса положены ИИ-чипы собственной разработки SN40L. Эти изделия состоят из двух крупных чиплетов, оперирующих 520 Мбайт SRAM-кеша, 1,5 Тбайт DDR5 DRAM, а также 64 Гбайт высокоскоростной памяти HBM3. Утверждается, что восьмипроцессорная система на базе SN40L способна запускать и обслуживать ИИ-модели с 5 трлн параметров и глубиной запроса более 256к. Платформа SambaNova Cloud, по заявлениям разработчиков, демонстрирует производительность до 132 токенов в секунду при работе с Llama 3.1 405B и до 461 токена в секунду при использовании Llama 3.1 70B. Для сравнения, по оценкам Artificial Analysis, даже самые мощные системы на базе GPU могут обслуживать модель Llama 3.1 405B только со скоростью 72 токена в секунду, а большинство из них намного медленнее. Подчёркивается, что SambaNova Cloud демонстрирует рекордную скорость при сохранении полной 16-битной точности. Однако без компромиссов всё же не обошлось: модель работает не в полном контекстном окне в 128k, а при 8k. Доступ к SambaNova Cloud предоставляется по трём схемам — Free, Developer и Enterprise. Первая предусматривает бесплатное базовое использование через API. Схема для разработчиков Developer (появится к концу 2024 года) позволяет работать с моделями Llama 3.1 8B, 70B и 405B с более высокими лимитами. Наконец, план Enterprise предлагает корпоративным клиентам возможность масштабирования для поддержки ресурсоёмких рабочих нагрузок. Ранее Cerebras Systems тоже объявила о запуске «самой мощной в мире» ИИ-платформы для инференса, а Groq ещё в прошлом году говорила о преимуществах своих решений и тоже переключилась на создание облачных сервисов. Впрочем, в бенчмарках MLPerf Inference по-прежнему бессменно лидируют решения NVIDIA.

29.02.2024 [13:01], Владимир Мироненко

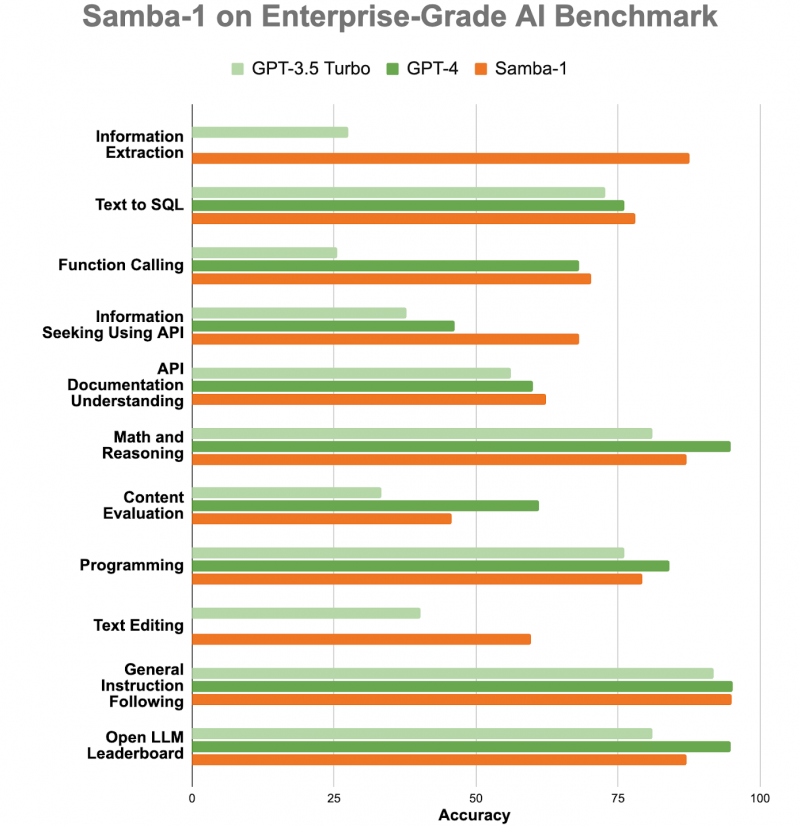

ИИ-консилиум: корпоративная LLM Samba-1 c 1 трлн параметров объединила более 50 открытых моделейСтартап SambaNova Systems представил Samba-1, модель генеративного ИИ с 1 трлн параметров, предназначенную для использования предприятиями. SambaNova описывает новую модель как «объединение экспертных архитектур» (Composition of Experts, CoE), которое включает более 50 открытых моделей генеративного ИИ высочайшего качества, в том числе Llama2 7B/13B/70B, Mistral 7B, DeepSeek Coder 1.3B/6.7B/33B, Falcon 40B, DePlot, CLIP, Llava. В частности, Llama 2 может генерировать текст, создавать программный код и решать математические задачи. Есть и более специализированные LLM, такие как DePlot от Google, которая может вводить информацию из диаграмм и других визуализаций данных в электронную таблицу. Samba-1 уже используется клиентами и партнёрами SambaNova, включая Accenture и NetApp. SambaNova позиционирует Samba-1 как первую модель с 1 трлн параметров для предприятий с регулируемой деятельностью, которая является приватной, безопасной и на порядок более эффективной, чем любая другая модель такого размера. Заказчик может установить контроль доступа к данным для отдельных пользователей. Желающие могут ознакомиться с работой модели. По словам главы SambaNova, Samba-1 оптимизирована для работы с чипом SN40L, выпущенным стартапом прошлой осенью. «Samba-1 способна конкурировать с GPT-4, но она лучше подходит для предприятий, поскольку её можно развернуть как локально, так и в частном облаке, чтобы клиенты могли точно настроить модель с использованием своих личных данных, не отдавая их в открытый доступ», — добавил он. SambaNova утверждает, что инференс этой модели обходится в десять раз дешевле, чем для конкурирующих LLM. Получив запрос, Samba-1 решает, какая из её внутренних моделей лучше всего приспособлена для его обработки, и поручает ей сгенерировать ответ. То есть активируется только одна из относительно небольших моделей, тогда как традиционные монолитные LLM требуют активации целиком. Стартап SambaNova привлёк около $1 млрд инвестиций от ряда компаний, включая Intel Capital и GV (инвестиционное подразделение Alphabet Inc). По итогам раунда финансирования в начале 2021 года рыночная стоимость стартапа оценивается в более чем $5 млрд. |

|